Le règlement européen sur l’intelligence artificielle, appelé AI Act, introduit une approche fondée sur le risque pour encadrer l’utilisation de l’IA. Il impose des exigences spécifiques aux systèmes d’IA à haut risque (SIAHR), c’est-à-dire ceux susceptibles d’avoir un impact significatif sur les droits fondamentaux, la santé ou la sécurité. Une consultation publique est actuellement ouverte pour clarifier la classification des systèmes concernés, les exceptions possibles et les obligations liées à leur mise sur le marché.

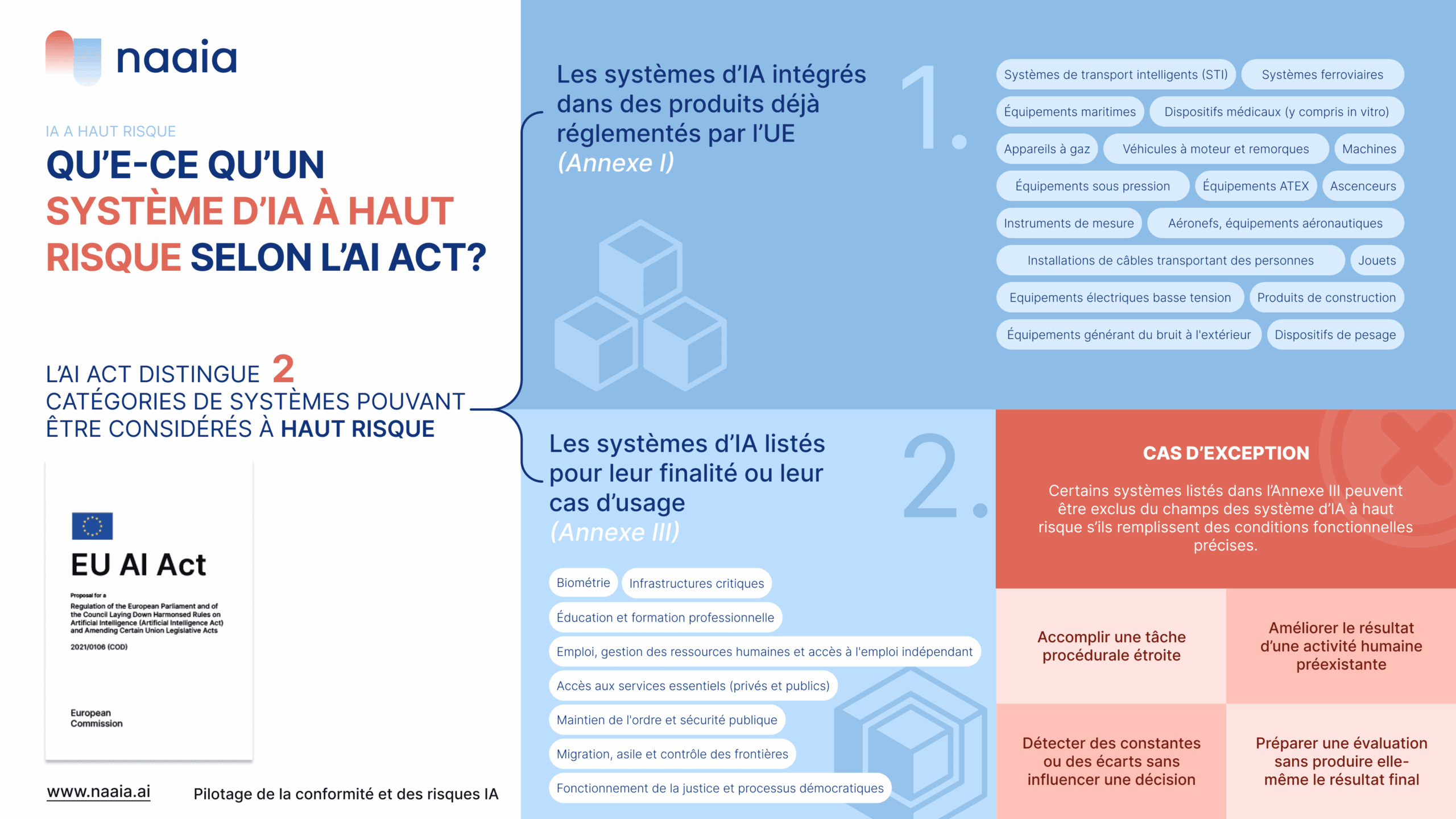

Qu’est-ce qu’un système d’IA à haut risque selon l’AI Act ?

L’AI Act distingue deux catégories de systèmes pouvant être considérés comme à haut risque :

- Les systèmes d’IA intégrés dans des produits déjà réglementés par l’UE (Annexe I)

- Les systèmes d’IA listés pour leur finalité ou leur cas d’usage (Annexe III)

Dans les deux cas, ces systèmes sont soumis aux exigences du Titre III du règlement, notamment en matière de gestion des risques, de transparence et de surveillance humaine.

1. Systèmes IA réglementés : produits encadrés par d’autres lois européennes

Certains produits sont déjà soumis à une évaluation de conformité au titre d’une législation sectorielle. Lorsqu’un système IA est intégré à un de ces produits, il est automatiquement considéré à haut risque.

Produits visés :

- Dispositifs médicaux (y compris in vitro)

- Machines

- Véhicules à moteur et remorques

- Systèmes ferroviaires

- Aéronefs, équipements aéronautiques

- Équipements maritimes

- Appareils à gaz

- Équipements sous pression

- Équipements ATEX

- Jouets

- Equipements électriques basse tension

- Dispositifs de pesage

- Instruments de mesure

- Ascenseurs

- Produits de construction

- Équipements de protection individuelle

- Installations de câbles transportant des personnes

- Équipements générant du bruit à l’extérieur

- Systèmes de transport intelligents (STI)

Ces produits sont jugés sensibles car leur bon fonctionnement a un impact direct sur la sécurité publique ou les droits des utilisateurs.

2. Liste complète des cas d’usage IA à haut risque

L’Annexe III du règlement AI Act identifie huit catégories de cas d’usage pour lesquels les systèmes d’IA sont automatiquement considérés comme à haut risque, en raison de leur impact potentiel sur les droits, la santé ou la sécurité des personnes. Ces domaines recouvrent des fonctions sensibles dans la vie sociale, économique ou démocratique. Voici le détail complet des cas d’usage concernés :

Catégorie 1. Biométrie

- Identification biométrique à distance en temps réel ou a posteriori dans des espaces accessibles au public

- Catégorisation biométrique selon des attributs sensibles (origine ethnique, orientation sexuelle, etc.)

- Reconnaissance des émotions à partir d’images ou de signaux physiologiques

Catégorie 2. Infrastructures critiques

- Systèmes d’IA utilisés comme composants de sécurité pour gérer l’approvisionnement en eau, électricité, gaz ou chauffage

- Systèmes liés à la gestion du trafic routier ou des infrastructures numériques critiques

Catégorie 3. Éducation et formation professionnelle

- Accès ou admission à des établissements d’enseignement

- Évaluation des acquis, orientation des élèves, personnalisation des parcours pédagogiques

- Surveillance des examens (détection de comportements suspects)

Catégorie 4. Emploi, gestion des ressources humaines et accès à l’emploi indépendant

- Recrutement automatisé : diffusion d’offres, présélection, notation des candidats

- Prise de décisions RH : promotion, licenciement, affectation de tâches

- Suivi des performances et comportement des employés

Catégorie 5. Accès aux services essentiels (privés et publics)

- Attribution ou retrait de prestations sociales, soins de santé ou aides publiques

- Évaluation de solvabilité et notation de crédit (hors détection de fraude)

- Évaluation des risques et tarification en assurance vie et santé

- Traitement et hiérarchisation des appels d’urgence

Catégorie 6. Maintien de l’ordre et sécurité publique

- Évaluation du risque de victimisation ou de récidive

- Utilisation de systèmes type polygraphe ou détection de mensonge

- Appréciation de la fiabilité de preuves dans le cadre d’enquêtes

- Profilage prédictif (hors fondement exclusif sur le profilage automatisé)

Catégorie 7. Migration, asile et contrôle des frontières

- Évaluation de risques liés à la sécurité ou à l’immigration

- Aide à l’examen des demandes d’asile, de visa ou de titre de séjour

- Identification automatisée des personnes (hors simple contrôle documentaire)

Catégorie 8. Fonctionnement de la justice et processus démocratiques

- Aide à la prise de décision par les juges ou dans les modes alternatifs de règlement des litiges

- Systèmes visant à influencer directement le vote ou le comportement électoral des citoyens

Dans tous ces cas, les systèmes doivent respecter les obligations strictes prévues par le Titre III du règlement, à moins qu’ils ne remplissent les conditions d’exclusion définies à l’article 6(2).

3. Cas d’exemption : quand un système IA n’est pas considéré comme à haut risque

Certains systèmes listés dans l’Annexe III peuvent être exclus du champ des SIAHR s’ils remplissent des conditions fonctionnelles précises. L’objectif de cette clause est d’éviter de sur-réglementer des usages techniques à faible impact. Pour bénéficier de cette exception, un système d’IA doit répondre à l’un des cas suivants :

- Accomplir une tâche procédurale étroite : il s’agit d’un système qui exécute une tâche bien délimitée et à faible enjeu, comme transformer des données non structurées en données structurées, trier des documents entrants ou détecter des doublons.

- Améliorer le résultat d’une activité humaine préexistante : l’IA n’est pas autonome dans sa décision, mais vient compléter une action humaine, par exemple en reformulant un texte dans un style professionnel ou académique, ou en l’adaptant à une charte éditoriale.

- Détecter des constantes ou des écarts sans influencer une décision : l’IA intervient a posteriori pour signaler une anomalie éventuelle, sans modifier ni influencer directement le jugement humain. Par exemple, elle peut analyser les écarts dans la notation d’un enseignant par rapport à ses habitudes passées.

- Préparer une évaluation sans produire elle-même le résultat final : cela concerne les IA qui facilitent un traitement en amont (indexation, traduction, reconnaissance de texte ou de parole), sans prendre part à la décision finale.

Ces systèmes doivent cependant faire l’objet d’une analyse rigoureuse pour vérifier qu’ils n’ont ni autonomie décisionnelle, ni impact direct sur les droits des personnes.

Quelles obligations pour les systèmes d’IA à haut risque ?

Les fournisseurs de SIAHR doivent respecter plusieurs obligations clés pour garantir leur conformité au AI Act :

- Gestion des risques tout au long du cycle de vie du système (article 9) : mise en place d’un processus continu, planifié et itératif, prenant en compte les risques connus ou prévisibles.

- Documentation technique exhaustive

- Transparence vis-à-vis des utilisateurs

- Surveillance humaine appropriée

- Système de gestion de la qualité

L’objectif est de s’assurer que le système fonctionne comme prévu, dans un cadre contrôlé, avec des garanties pour les individus affectés.

Comprendre les catégories et obligations des systèmes à haut risque est essentiel pour anticiper la conformité réglementaire. Le texte de l’AI Act pose un cadre clair, mais appelle une analyse fonctionnelle rigoureuse de chaque cas d’usage.

Laïus consultation publique : Une consultation publique est actuellement ouverte pour clarifier la classification des systèmes concernés, les exceptions possibles et les obligations liées à leur mise sur le marché.

Vous concevez ou utilisez une IA potentiellement à haut risque ?

Assurez-vous d’être en conformité avec l’AI Act, demandez une démo de Naaïa.