Introduction

Dans un paysage de l’IA qui évolue rapidement, la multiplication des cadres réglementaires visant à orienter le développement et le déploiement responsables de l’IA est devenue à la fois une nécessité et un défi. Si ce corpus croissant témoigne d’un engagement mondial à traiter les implications éthiques, juridiques et sociétales de l’IA, il présente également des risques, notamment la duplication des réglementations et la surgénéralisation. Les organisations doivent faire face à la complexité de la sélection des cadres qui s’alignent sur leurs besoins et leur stratégie unique, en équilibrant la conformité et l’innovation.

Chez Naaia, nous nous engageons à rester à la pointe de la conformité réglementaire en matière d’IA. En intégrant à notre solution les réglementations de régions clés telles que l’Union Européenne, les États-Unis et la Chine, nous avons établi une base solide pour la gestion des risques et de la conformité en matière d’IA. Nos dernières intégrations des cadres ISO/IEC 42001, NIST AI RMF et LNE Certification de processus pour l’IA renforcent encore notre capacité à répondre aux besoins spécifiques de nos clients et de l’industrie de l’IA au sens large. Dans cet article, nous allons explorer individuellement chaque cadre, puis fournir une analyse comparative mettant en évidence leurs contributions uniques, et enfin aborder leur impact sur les offres de conformité de Naaia.

Les cadres : Qui, quoi, comment et pourquoi

ISO/IEC 42001

La norme ISO/IEC 42001 est la première approche normalisée au monde en matière de gestion de l’intelligence artificielle. Il s’agit d’une norme internationale qui spécifie les exigences relatives à l’établissement, à la mise en œuvre, au maintien et à l’amélioration continue d’un système de gestion de l’intelligence artificielle (AIMS) au sein des organisations. Un système de gestion, tel que défini dans l’ISO/IEC 42001 (3.4), est un » ensemble d’éléments interdépendants ou en interaction d’une organisation afin d’établir des politiques et des procédures, les objectifs, ainsi que les processus permettant d’atteindre ces objectifs« .

Il est donc conçu pour les entités qui fournissent ou utilisent des produits ou des services basés sur l’IA, afin de garantir que le développement et l’utilisation des systèmes d’IA sont responsables, éthiques et conformes aux objectifs de l’organisation.

Structure

L’ISO établit une feuille de route des exigences fondamentales pour un AIMS complet. Son approche comporte plusieurs étapes :

Contexte de l’organisation : Il s’agit de comprendre et d’examiner le contexte, les activités et les objectifs de l’Organisation, y compris les besoins et attentes des parties prenantes et de mettre en place un système de gestion de l’IA[SP1] ayant un périmètre clair et défini.

Leadership[SP2] : Il s’agit de la structure organisationnelle de l’élément de leadership, que la norme considère comme de la plus haute importance et qui se concentre sur l’engagement[SP3] de la direction et ses répercussions sur l’ensemble des parties prenantes, la politique en matière d’IA et l’attribution des rôles, responsabilités et autorités au sein de l’Organisation.

Rôles, responsabilités et autorités [LA4] Il s’agit pour la direction générale d’attribuer et de communiquer les responsabilités et pouvoirs nécessaires pour assurer la conformité du système de gestion de l’IA et en rendre compte à la direction générale.

Planification : L’étape suivante consiste à planifier les actions permettant de mitiger les risques et gérer les opportunités. Il est nécessaire de planifier l’évaluation des risques spécifiques à l’IA, leur traitement, l’évaluation de l’impact du système d’IA, l’atteinte des objectifs de l’IA, les changements. [SP5]

Soutien : Cette étape détaille les mécanismes de soutien tels que les ressources[SP6] nécessaires au système management de l’IA, les compétences, la sensibilisation, la communication et le contrôle de la documentation.

Evaluation des performances : Elle est guidée par l’audit, les mesures de performances, la suivi effectué par l’encadrement supérieur (revue de direction).[SP7]

Amélioration : L’amélioration continue est réalisée à travers, la mise en œuvre d’audit, de la gestion des changements, du management des non conformités et corrections et de la collecte des retours utilisateurs.[SP8]

Analyse

L’un des aspects importants de la norme ISO/IEC 42001 est son adaptabilité et sa nature non contraignante. La norme est une certification volontaire, ce qui signifie qu’elle n’est pas une exigence obligatoire pour les organisations. La caractéristique la plus déterminante de la norme ISO/IEC 42001 est l’accent mis sur l’approche adoptée par l’Organisation pour mettre en place et maintenir un AIMS performant. Les politiques de l’ISO permettent une certaine flexibilité en fonction de l’ampleur, de la nature et du contexte de l’utilisation de l’IA au sein d’une organisation, ainsi que des systèmes d’IA spécifiques de l’Organisation, des risques associés et de l’impact de l’IA sur les parties prenantes. Cette adaptabilité rend la norme applicable à divers secteurs et contextes, des startups aux grandes entreprises. Il s’agit d’un cadre très axé sur l’Organisation.

Dans l’ensemble, la norme ISO/IEC 42001 se concentre sur les pratiques de gestion interne, aidant les Organisations à répondre à des exigences réglementaires plus larges, ce qui en fait un outil précieux à adopter et à adapter à toutes les exigences réglementaires qui peuvent se présenter, y compris celles de l’AI Act.

NIST AI RMF

Le NIST AI RMF est une ligne directrice complète élaborée par le National Institute of Standards and Technology (NIST) américain qui a été publiée en janvier 2023. Il s’agit d’un cadre volontaire non sectoriel, préservant les droits[SP9] [LA10] , dont l’objectif est de guider les Organisations impliquées dans la conception, le développement, le déploiement et l’utilisation de systèmes d’IA afin de gérer les risques liés à l’IA et de promouvoir leur utilisation et leur développement en toute confiance.

Le NIST AI RMF met l’accent sur l’atténuation des impacts négatifs et des préjudices causés aux personnes, aux organisations et aux écosystèmes par les systèmes d’IA. En proposant des approches structurées pour gérer les dommages potentiels, le cadre vise à favoriser des technologies d’IA plus fiables et à maximiser les résultats positifs[SP11] [LA12] des systèmes d’IA.

La norme définit également les principales caractéristiques d’une IA digne de confiance, à savoir valide et fiable, sûre, sécurisée et résiliente, responsable et transparente, explicable et interprétable, respectueuse de la vie privée et équitable, avec gestion des préjugés nuisibles. Ces lignes directrices constituent une base solide pour le développement de technologies d’IA éthiques, fiables et bénéfiques pour la société dans son ensemble.

Structure

Ce cadre s’articule autour de quatre fonctions essentielles : GOVERN, MAP, MEASURE et MANAGE. Chaque fonction est ensuite divisée en catégories et sous-catégories avec des suggestions d’actions :

GOVERN (Gouverner) : Cette fonction vise à favoriser une culture de gestion des risques dans l’IA, en fournissant des processus permettant d’identifier, d’évaluer et de gérer les risques tout en alignant la conception des systèmes d’IA sur les valeurs et les principes de l’Organisation tout au long du cycle de vie du produit.

MAP (Cartographier) : Cette fonction vise à établir le contexte et à déterminer les risques liés à l’IA en améliorant la capacité à évaluer et à comprendre les systèmes d’IA. Il s’agit notamment de vérifier les hypothèses, de reconnaître lorsque les systèmes fonctionnent en dehors de leur utilisation prévue, d’identifier les applications positives et les limites, et d’anticiper les risques, y compris les incidences négatives potentielles des utilisations prévues et non prévues.

MEASURE (Mesurer) : Cette fonction utilise des outils pour évaluer et surveiller les risques liés à l’IA identifiés dans le cadre de la fonction MAP, en suivant les paramètres relatifs à l’IA digne de confiance et à l’impact social par le biais de tests rigoureux et d’examens indépendants. Ses résultats informent la fonction MANAGE pour une surveillance et une réponse efficace aux risques.

MANAGE (Gérer) : Cette fonction permet d’allouer des ressources pour faire face aux risques liés à l’IA, cartographiés et mesurés au moyen des pratiques établies dans le cadre de la fonction GOVERN. Elle comprend la planification de la réponse, de la récupération et de la communication concernant les incidents ou les événements.

La norme propose des actions, qui ne sont toutefois pas censées constituer une liste de contrôle ou une séquence d’étapes, mais qui peuvent être résumées comme suit : elle commence par la mise en place de structures de gouvernance, suivies de la cartographie du contexte, puis de la mesure des risques et enfin de la gestion des risques. Même si la norme peut être utilisée pour déterminer les priorités en matière de risques, elle ne définit pas de tolérance spécifique à l’égard des risques.

Analyse

Le NIST AI RMF adopte une approche globale et solide de la gestion des risques liés à l’IA, en tenant compte des facteurs techniques, éthiques, juridiques et sociétaux. Sa structure agnostique en matière de réglementation et de droit permet aux organisations de tous les secteurs d’adapter le cadre à leurs besoins spécifiques et peut servir de complément à d’autres cadres réglementaires pertinents auxquels une organisation doit se conformer. Il permet aux organisations de comprendre comment gérer les risques tout au long du cycle de vie du système d’IA, et permet une surveillance et une adaptation continues, en reconnaissant que les risques liés à l’IA évoluent avec le temps, y compris ceux qui n’ont pas été anticipés.

Il donne également des indications sur les défis que pose la gestion des risques liés à l’IA, tels que la mesure des risques, y compris ceux provenant de tiers, l’identification d’une tolérance au risque, que le NIST ne prescrit pas, la hiérarchisation des risques, ainsi que l’intégration et la gestion des risques.

En s’alignant sur le NIST AI RMF, les Organisations peuvent améliorer leurs processus de gouvernance, de cartographie, de mesure et de gestion des risques liés à l’IA, tout en améliorant la documentation des résultats. Cet alignement favorise une meilleure prise de conscience des compromis en matière de fiabilité et des risques liés à l’IA, soutient une prise de décision claire pour le déploiement des systèmes et renforce la responsabilité et la culture organisationnelles autour de la gestion des risques liés à l’IA. En outre, le norme encourage un meilleur partage de l’information, une compréhension plus approfondie des risques en aval, un engagement plus fort des parties prenantes et une meilleure capacité de test, d’évaluation, de validation et de vérification (TEVV) des systèmes d’IA.

Bien qu’élaboré aux États-Unis, le NIST AI RMF est une norme mondialement reconnue et considérée comme un guide précieux pour satisfaire aux normes internationales en matière d’intelligence artificielle. Son alignement sur les réglementations mondiales la rend utile aux Organisations du monde entier pour construire des systèmes d’IA dignes de confiance et conformes.

Certification du processus LNE pour l’IA : conception, développement, évaluation et maintien en conditions opérationnelles

La Certification de processus pour l’IA : Conception, développement, évaluation et maintien en conditions opérationnelles, est une certification conçue par le Laboratoire National d’Essais (LNE), un organisme de tests et d’évaluation de premier plan en France, en 2021, visant à aider les entreprises engagées dans le développement, la fourniture ou l’utilisation de systèmes d’IA, à intégrer, adopter et systématiser les meilleures pratiques tout au long du cycle de vie de l’IA. En fournissant des références claires et objectives, la certification LNE aide les développeurs à adhérer à des références techniques solides et permet aux utilisateurs d’adopter en toute confiance des solutions d’IA.

La certification est fortement axée sur les processus et définit des exigences techniques spécifiques pour chaque phase du cycle de vie de l’IA. Elle est également indépendante du secteur, ce qui signifie qu’elle s’adresse à toutes les industries. Son champ d’application englobe tous les processus liés aux systèmes d’IA basés sur l’apprentissage automatique, y compris l’IA statique, incrémentale et hybride. Il exclut toutefois les systèmes d’IA purement symboliques.

Structure

La structure de la certification LNE s’aligne sur le cycle de vie des systèmes d’intelligence artificielle, en établissant des processus clairs pour chaque phase :

Phase de conception : Cette phase se concentre sur la transformation des besoins des utilisateurs en spécifications fonctionnelles, couvrant tous les choix ultérieurs, du développement et de l’assurance qualité à la communication. Au cours de cette phase, les caractéristiques de la conception sont alignées et vérifiées par rapport aux obligations normatives et réglementaires.

Phase de développement : Cette phase met en œuvre les processus conçus par le biais de choix de développement technique, y compris la gestion des données, les procédures de développement, les objectifs de traçabilité, les choix d’infrastructure, afin de créer une version du système d’IA prête pour une évaluation claire et une amélioration continue. Le cadre du LNE est très détaillé sur le plan technique en ce qui concerne les exigences en matière de gestion des données et de traçabilité.

Phase d’évaluation : Cette phase permet de valider si le système d’IA répond aux spécifications définies avant son déploiement, au moyen d’un protocole d’évaluation complet et structuré, comprenant des procédures de test de performance, de qualité, de sécurité et de transparence.

Phase de maintenance en conditions opérationnelles : Après le déploiement, le système d’IA est étroitement surveillé dans des conditions opérationnelles afin de garantir sa fiabilité, sa sécurité et sa conformité après le déploiement. Cette surveillance porte sur les dégradations potentielles des performances et de la conformité tout au long du cycle de vie du système et fait appel à des mécanismes spécifiques pour les contrôler et les corriger. Il s’agit par exemple de surveiller en permanence les caractéristiques afin de maintenir des conditions de fonctionnement optimales.

Les exigences en matière de communication et de documentation servent de piliers fondamentaux tout au long de ces phases, favorisant la transparence, le partage d’informations et l’amélioration continue.

Analyse

Ce qui distingue la certification LNE, c’est qu’elle met l’accent sur les processus de manière exhaustive et technique. La certification se concentre sur la fonctionnalité de l’IA elle-même et sur la manière dont sa conception, sa mise en œuvre, ses essais et sa maintenance respectent les normes les plus strictes en matière de sécurité, de performance et de conformité. Cette approche neutre du point de vue de l’Organisation et du secteur facilite la définition d’exigences largement applicables, qui peuvent être facilement traduites en exigences légales/organisationnelles ainsi qu’en références techniques.

Le cadre LNE favorise également l’alignement sur les réglementations sectorielles et la législation émergente. Bien qu’il soit axé sur les processus, le cadre LNE intègre également des principes de gestion des risques, définissant des exigences en matière de gestion des risques, d’utilisation éthique de l’IA et de résilience de la chaîne d’approvisionnement. Il définit également des exigences de conformité dans toutes les phases du cycle de vie de l’IA afin de répondre à une variété de normes et de réglementations et d’attirer l’attention de tous les professionnels travaillant dans la phase correspondante du développement ou du déploiement de l’IA sur les principes juridiques et éthiques d’une manière structurée.

Comparaison

Typologie et force contraignante

L’ISO 42001, le NIST AI RMF et le LNE sont tous des cadres volontaires sur l’IA digne de confiance. Les organisations peuvent également choisir d’être certifiées par ces normes, à l’exception du NIST AI RMF qui n’est pas un processus de certification. Cependant, une fois que les Organisations s’engagent dans ce processus de certification, elles deviennent liées par les obligations de ces cadres spécifiques (ISO, LNE).

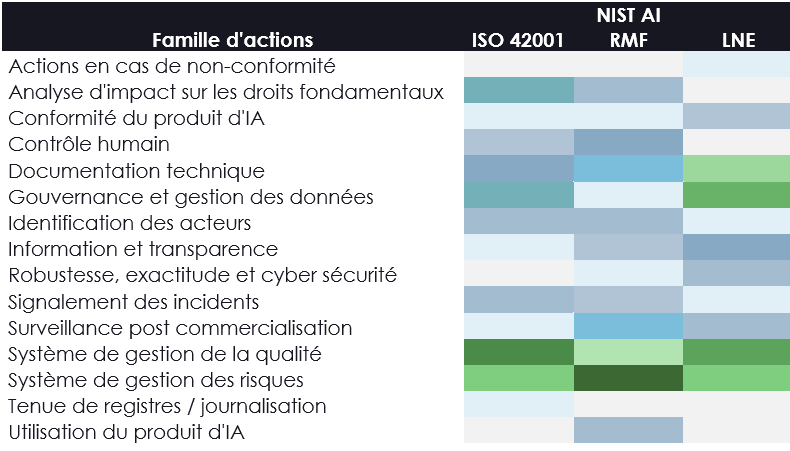

Un tableau comparatif ci-dessous résume et compare chaque standard par famille d’actions, mettant en évidence les principales orientations et approches que chaque standard propose.

Principales approches

La norme ISO 42001 est axée sur un cadre de gestion complet de l’IA dans l’ensemble de l’organisation, offrant une approche holistique de la gestion des systèmes d’IA. Elle met l’accent sur un vaste cadre de gouvernance et sur l’intégration des meilleures pratiques tout au long du cycle de vie des systèmes d’IA ; le NIST AI RMF, quant à lui, se concentre davantage sur un cadre de gestion des risques qui met l’accent sur une approche structurée de l’identification, de la mesure et de l’atténuation des risques, en se concentrant sur la garantie de la fiabilité des systèmes d’IA ; pour le LNE, il est plus spécifique aux processus impliqués dans le développement et la gestion du cycle de vie de l’IA, en mettant fortement l’accent sur l’éthique, la fiabilité et la qualité de la solution. Il s’agit donc d’un cadre technique basé sur les processus.

Principaux objectifs

La norme ISO 42001 fournit un cadre solide pour le développement, le déploiement et l’utilisation responsables des systèmes d’IA. Elle vise à assurer la conformité avec les réglementations (European AI Act), à améliorer continuellement les processus internes et à garantir la sécurité, l’équité, la transparence et la traçabilité par le biais de politiques adaptées à l’organisation.

Le NIST AI RMF fournit un cadre complet pour la gestion des risques liés à l’IA tout au long du cycle de vie des systèmes d’IA, avec pour objectif principal de favoriser la confiance en abordant des questions telles que l’équité, la transparence, la responsabilité et la sécurité. Le cadre met l’accent sur l’amélioration continue des pratiques de gouvernance et de gestion des risques liés à l’IA. En proposant une approche structurée pour cartographier, mesurer et gérer ou atténuer les risques liés à l’IA, le NIST AI RMF aide les organisations à développer des systèmes d’IA responsables et dignes de confiance. Il encourage un large engagement des parties prenantes et l’intégration de diverses perspectives, notamment le retour d’information, ce qui en fait un outil polyvalent pour parvenir à une gestion efficace et éthique de l’IA à l’échelle mondiale.

Le LNE cherche à certifier la qualité des processus et à démontrer la maîtrise du cycle de vie des systèmes d’IA. Cette certification garantit que les solutions d’IA répondent aux exigences de sécurité, de respect de la vie privée, de conformité et de performance, en veillant tout particulièrement à éviter les biais et à garantir la robustesse du système. Contrairement à l’ISO et au NIST, le LNE définit des exigences équilibrées pour la conception, le développement, l’évaluation et la maintenance/surveillance des systèmes d’IA. À cet égard, il est plus technique que les deux autres cadres, élaborant des exigences spécifiques qui vont au-delà de la gestion des risques et de la qualité.

Public cible et avantages

La norme ISO 42001 s’adresse aux entreprises qui cherchent à structurer et à gérer leurs systèmes d’IA à l’échelle de l’organisation, en promouvant une dynamique d’amélioration continue. Elle vise à renforcer la confiance des parties prenantes (internes et externes) grâce à une gouvernance solide. Son principal avantage réside précisément dans cette approche organisationnelle et de gestion de la qualité, qui fournit une feuille de route adaptable aux objectifs et à la taille de l’organisation. ISO/IEC 42001 est une norme internationalement reconnue qui fournit un cadre mondial pour une gouvernance responsable de l’IA, offrant une crédibilité et une reproductibilité plus larges que les cadres NIST et LNE spécifiques à chaque région, qui sont adaptés respectivement aux marchés des États-Unis et de l’Union européenne.

La NIST AI RMF s’adresse principalement à un large éventail d’acteurs de l’IA et d’organisations impliquées dans le cycle de vie de l’IA, notamment dans la conception, le développement, le déploiement et l’évaluation, l’utilisation et la gestion des risques des systèmes d’IA. Sa principale distinction par rapport à l’ISO et à la LNE est qu’elle met davantage l’accent sur l’aspect « système de gestion des risques » des systèmes d’IA que les deux autres normes, qui se concentrent davantage sur l’aspect « système de gestion de la qualité ».

La certification LNE s’adresse aux développeurs, fournisseurs et intégrateurs d’IA qui souhaitent démontrer leur maîtrise de l’ensemble du cycle de vie de l’IA et un niveau accru de raffinement technique, tout en garantissant des normes de performance, de conformité et d’éthique. La principale différence avec les cadres NIST et ISO est l’accent mis sur la fonctionnalité de l’IA elle-même et l’approche technique attentive de tous les processus liés au développement, à la gestion et au déploiement de l’IA.

Relation avec l’AI Act

Le NIST AI RMF, l’ISO/IEC 42001 et le LNE sont tous des cadres volontaires, ce qui signifie que, contrairement à l’AI Act, les organisations choisissent de s’aligner sur ces cadres, sans aucune obligation contraignante. Les organisations peuvent également choisir d’être certifiées ISO/IEC 42001 et LNE (contrairement au NIST AI RMF).

Ces trois normes sont également censées compléter l’AI Act et d’autres réglementations, car elles soulignent toutes la nécessité de mettre en place des processus et des politiques solides en tant qu’outils pour améliorer la conformité. Elles partagent également une approche similaire de la qualité et de la gestion des risques, comme l’importance des évaluations de conformité, l’amélioration de l’interopérabilité et la garantie d’une utilisation fiable et responsable de l’IA.

Les certifications ISO/IEC 42001 et LNE apportent toutes deux une contribution précieuse au cadre de gouvernance de l’IA d’une organisation, en complément de l’AI Act. La norme ISO 42001 propose une approche organisationnelle globale, tandis que la norme LNE se concentre sur les aspects techniques et procéduraux des fonctionnalités de l’IA, améliorant ainsi la gouvernance globale de l’IA. Le NIST AI RMF va encore plus loin en abordant les risques liés à l’IA dans tous les systèmes, y compris ceux qui ne sont pas classés comme étant à haut risque par l’AI Act.

Les trois cadres – ISO 42001, LNE et NIST AI RMF – peuvent fonctionner en synergie avec l’AI Act et d’autres réglementations pertinentes en matière d’IA. Ils soulignent l’importance de processus et de politiques solides, d’évaluations de la conformité et d’évaluations, améliorant ainsi leur interopérabilité et favorisant une gestion efficace de la conformité et des risques.